AGV(自动导引车)视觉避障的核心是通过摄像头或深度传感器(如激光雷达、RGB-D相机)获取环境信息,结合计算机视觉算法实时识别障碍物并规划路径。其基本流程包括:

环境感知:

单目/双目摄像头:通过图像特征提取(如边缘检测、纹理分析)或深度学习模型(如YOLO、SSD)识别障碍物。

深度传感器:利用激光雷达(LiDAR)或结构光技术获取三维点云数据,直接测量障碍物距离。

障碍物检测与定位:

基于深度学习的语义分割(如Mask R-CNN)或传统几何方法(如霍夫变换)识别障碍物边界。

通过SLAM(同步定位与地图构建)技术实时更新障碍物位置。

路径规划与决策:

结合动态窗口法(DWA)或A*算法,在避开障碍物的同时优化路径效率。

通过多传感器融合(如视觉+IMU+激光雷达)提升鲁棒性。

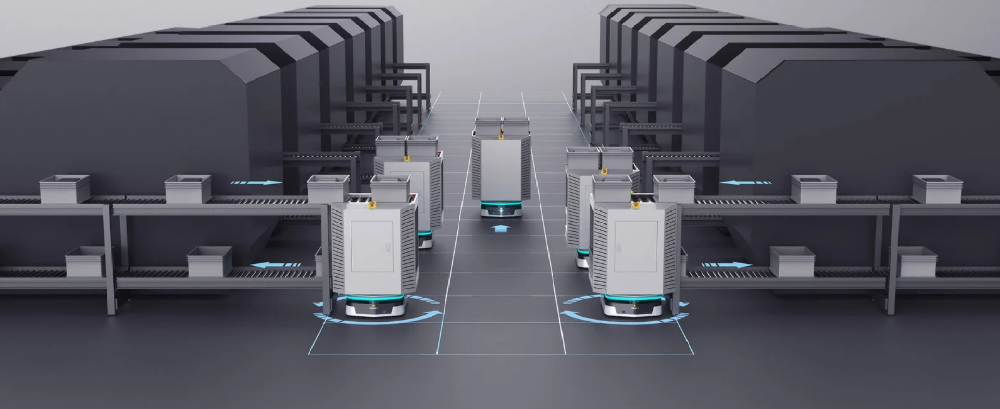

仓库货架拣选

在密集货架环境中,AGV需动态避开临时堆放的货物或人员,视觉避障可实时识别低矮障碍物(如纸箱),避免碰撞。

生产线搬运

在自动化产线中,AGV需与机械臂、传送带协同作业,视觉避障可识别移动设备或突发障碍,确保安全运行。

复杂物流中心

在多AGV协同场景中,视觉避障结合V2X通信(车与车通信)实现动态避让,提升整体效率。

动态人车混行环境

在医院、商场等场景中,AGV需识别行人、推车等非结构化障碍物,视觉避障通过行人检测算法(如YOLOv8)实现安全导航。

| 维度 | 优点 | 缺点 |

|---|---|---|

| 准确性 | - 可识别复杂形状、颜色、纹理的障碍物(如透明玻璃、软质物体)。 - 结合深度学习可提升小目标检测精度。 | - 受光照条件影响大(如强光、阴影)。 - 动态障碍物(如快速移动物体)易漏检。 |

| 稳定性 | - 非接触式感知,无机械磨损。 - 适应多场景(室内/室外、平坦/崎岖地面)。 | - 深度传感器成本较高(如高精度激光雷达)。 - 计算资源需求大(需GPU加速)。 |

| 实时性 | - 现代算法(如MobileNetV3)可实现30 FPS以上实时检测。 - 结合边缘计算可降低延迟。 | - 复杂场景下(如密集障碍物)处理速度下降。 - 通信延迟可能影响协同避障。 |

| 灵活性 | - 可通过软件升级快速适配新障碍物类型。 - 支持多传感器融合(如视觉+IMU)。 | - 依赖大量标注数据训练模型。 - 算法泛化能力有限(如跨场景性能下降)。 |

多模态融合与边缘计算

结合视觉、激光雷达、毫米波雷达等多传感器数据,通过边缘计算设备(如NVIDIA Jetson)实现低延迟、高鲁棒性避障。

深度学习与强化学习结合

利用强化学习(如PPO算法)优化避障策略,使AGV在复杂环境中自主学习最优路径。

轻量化模型与硬件加速

开发更高效的轻量化模型(如TinyML),结合FPGA或ASIC芯片实现低功耗实时避障。

数字孪生与仿真测试

通过数字孪生技术构建虚拟测试环境,加速避障算法的验证与优化。

标准化与开源生态

推动视觉避障算法的标准化(如ROS 2框架),构建开源数据集(如AGV-Obstacle Dataset)促进技术共享。

视觉避障是AGV机器人实现自主导航的核心技术之一,其优势在于高精度、高灵活性和非接触式感知,但需克服光照干扰、计算资源限制等挑战。未来,随着多模态融合、边缘计算和深度强化学习的发展,视觉避障将推动AGV向更安全、更智能的方向演进,为工业4.0和智慧物流提供关键支撑。