视觉导航是托盘机器人AGV实现自主定位与路径规划的核心技术之一,其核心原理是通过摄像头捕捉环境图像,结合计算机视觉算法提取特征信息,进而构建地图、识别位置并规划路径。以下从技术框架、关键算法、工作流程、优势与挑战四个维度展开详细介绍:

视觉导航系统由硬件层与软件层构成,二者协同实现环境感知与决策控制:

硬件层

传感器融合:

与激光雷达、IMU(惯性测量单元)、编码器等传感器数据融合,提升定位鲁棒性。

计算单元:

嵌入式处理器:如NVIDIA Jetson系列、Intel Movidius神经计算棒,支持实时图像处理与AI推理。

边缘计算设备:在AGV本体或云端部署,处理复杂算法(如SLAM、深度学习)。

摄像头:

类型:工业级单目/双目摄像头、RGB-D深度摄像头(如Kinect、Intel RealSense)、鱼眼摄像头(全景视角)。

参数:分辨率(如1080P、4K)、帧率(30-60fps)、视场角(FOV,如60°-180°)、动态范围(适应强光/弱光)。

布局:前置摄像头(主视角)、侧置摄像头(辅助避障)、顶部摄像头(俯视全局)。

软件层

操作系统:Linux(ROS、Ubuntu)、Windows IoT等,支持多线程任务调度。

算法库:OpenCV(图像处理)、PCL(点云处理)、TensorFlow/PyTorch(深度学习)。

中间件:ROS(机器人操作系统)提供通信框架,实现传感器数据、控制指令的模块化交互。

视觉导航的核心算法可划分为环境感知、定位建图、路径规划三个阶段,各阶段算法相互协作,实现自主导航:

环境感知:特征提取与语义理解

语义分割:

将图像划分为“可通行区域”“障碍物”“目标点”等语义类别,为路径规划提供语义级输入。

典型算法:U-Net、SegNet、DeepLab。

特征提取:

传统方法:通过SIFT、SURF、ORB等算法提取图像中的角点、边缘、纹理等特征点,构建特征描述子。

深度学习方法:使用CNN(卷积神经网络)自动学习图像特征,如YOLO(目标检测)、Mask R-CNN(实例分割),识别货架、托盘、障碍物等目标。

定位建图:构建环境模型与自身坐标

语义地图构建:

在传统SLAM地图基础上,叠加语义信息(如货架编号、产线工位),实现“语义+几何”混合地图。

前端(视觉里程计):通过相邻帧图像的特征匹配(如光流法、特征点跟踪),估计AGV的位姿变化(平移、旋转)。

后端(非线性优化):结合全局地图信息,优化位姿估计误差,构建一致的环境地图。

回环检测:识别已访问区域,消除累积误差,提升地图精度。

视觉SLAM(Simultaneous Localization and Mapping):

路径规划:从起点到终点的最优轨迹

行为决策:

根据路径规划结果,生成控制指令(如转向、加速、减速),驱动AGV执行任务。

局部路径规划:

结合实时感知的动态障碍物信息,使用DWA(动态窗口法)、TEB(Timed Elastic Band)等算法动态调整路径,避免碰撞。

全局路径规划:

基于语义地图,使用A、Dijkstra、RRT等算法规划全局路径,避开静态障碍物。

视觉导航AGV的工作流程可分为感知-决策-执行三个闭环,具体步骤如下:

图像采集

摄像头以设定帧率(如30fps)持续拍摄环境图像,传输至计算单元。

预处理

去噪:通过高斯滤波、中值滤波去除图像噪声。

增强:调整对比度、亮度,突出关键特征(如边缘、纹理)。

畸变校正:修正鱼眼摄像头等广角镜头的图像畸变。

特征提取与匹配

使用ORB、SIFT等算法提取当前帧图像的特征点,并与关键帧(地图中的参考图像)进行匹配,计算位姿变化。

位姿估计与地图更新

视觉里程计:根据特征匹配结果,估计AGV的相对位姿(Δx, Δy, Δθ)。

局部建图:将当前帧图像与局部地图融合,更新环境模型。

回环检测:通过词袋模型(Bag of Words)或深度学习模型识别已访问区域,优化全局地图。

路径规划与控制

全局规划:根据任务目标(如从仓库到产线)规划全局路径。

局部避障:结合实时感知的动态障碍物信息,动态调整路径。

运动控制:生成速度、转向指令,驱动AGV执行路径。

反馈与迭代

将实际运动数据(如编码器反馈)与视觉估计结果对比,修正误差,形成闭环控制。

优势

无标记部署:无需铺设磁条、二维码等地面标记,降低环境改造成本。

环境适应性强:可应对复杂、动态场景(如反光金属、弱光环境),通过深度学习提升鲁棒性。

语义理解能力:通过语义分割识别目标物体(如托盘、货架),支持更高级的任务(如“去A货架取第3层货物”)。

成本效益:相比激光雷达,摄像头成本更低,适合大规模部署。

挑战

光照敏感性:强光可能导致过曝,弱光可能降低特征识别率,需结合补光灯或红外摄像头。

动态障碍物处理:快速移动的物体(如人员、叉车)可能造成特征匹配失败,需结合激光雷达或IMU融合。

计算负载高:实时处理高分辨率图像(如4K)需高性能计算单元,可能增加功耗与成本。

长期稳定性:环境变化(如货架移位、光线季节性变化)需持续更新地图,维护复杂度较高。

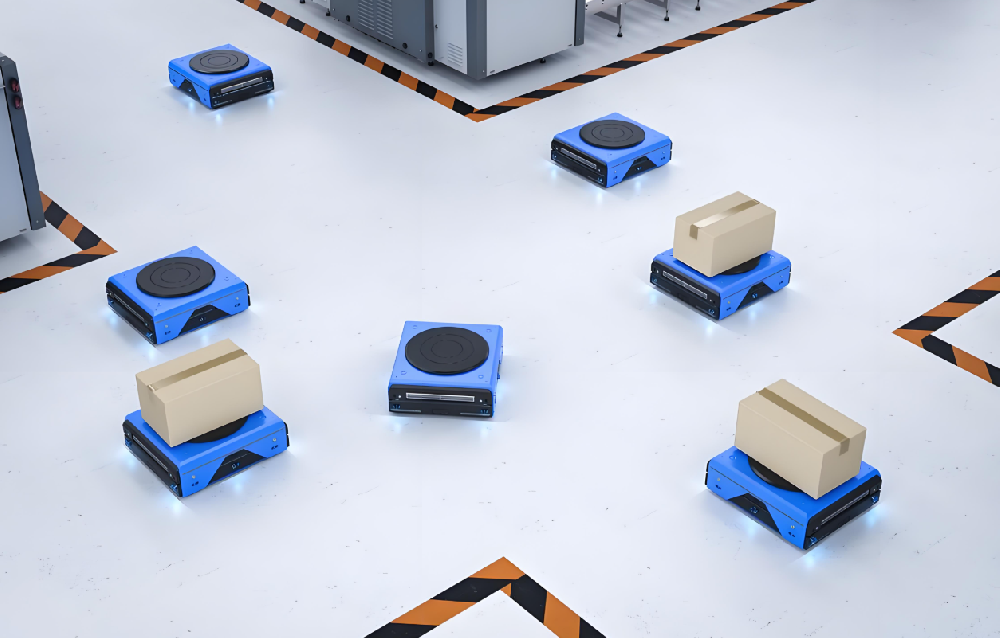

应用场景

仓储物流:在电商仓库中,AGV通过视觉导航识别货架编号与托盘位置,实现“货到人”精准拣选。

制造业产线:在汽车零部件工厂,AGV通过视觉定位产线工位,自动配送物料。

特殊环境:在反光金属车间或弱光仓库,视觉导航结合激光雷达实现鲁棒定位。

性能指标

定位精度:±5mm至±10mm(结合激光/IMU融合可达更高精度)。

建图速度:10-30帧/秒(依赖硬件性能)。

回环检测成功率:>95%(在典型仓库环境中)。

动态避障响应时间:<100ms(结合激光雷达可缩短至50ms)。

视觉导航通过“摄像头+算法”的软硬件协同,实现了托盘机器人AGV在复杂环境中的自主定位与路径规划。其核心优势在于无标记部署、语义理解与成本效益,但需解决光照敏感性、动态障碍物处理等挑战。未来,随着深度学习与多传感器融合技术的发展,视觉导航将向更高精度、更强鲁棒性方向演进,成为智慧工厂物流自动化的关键技术之一。